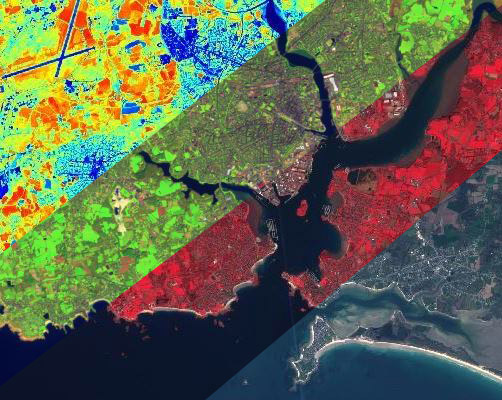

Des informations au-delà du visible (infrarouge, proche infrarouge) et régulièrement mises à jour permettant de visualiser l’état des couvertures terrestres (densité de végétation, teneur en eau de la végétation ou des sols, surfaces artificialisées, etc.)

Le Pôle Métier Télédétection est un groupe de travail ouvert à tous les partenaires GéoBretagne et toutes les personnes intéressées par les données d'observation de la Terre.

Copernicus Régional est la démarche régionale pour favoriser l'usage des données issues du programme Européen Copernicus et autres données d'observation de la Terre. Elle vise à simplifier l'accès à ces données par un point d'accès unique, à proposer assistance, entraide et mise en réseau pour l'usage de ces données, à initier et accompagner la co-constructions d'applications et services régionaux utilisant des données satellitaires.

Pour toute question, contribution, remarque, contactez-nous

Ce contenu est aussi disponible en fiches au format pdf Fiche "Comprendre une image satellitaire" Fiche "Contexte"

Les mots pour désigner les données présentées dans ce visualiseur sont nombreux (données de télédétection, produits satellitaires, imagerie spatiale...).

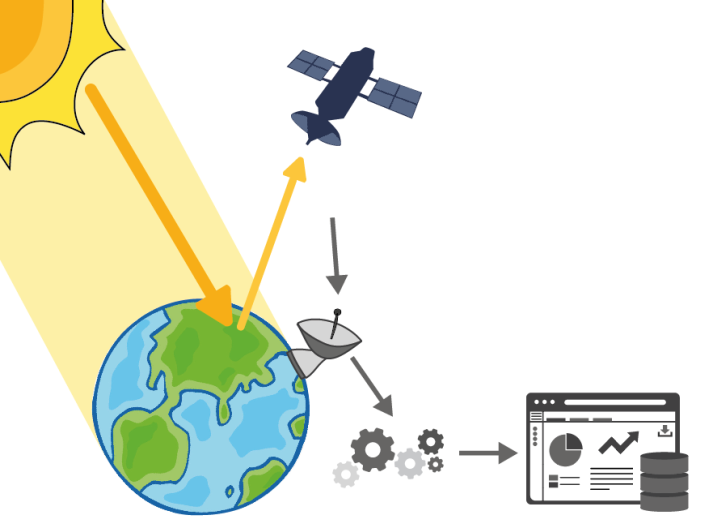

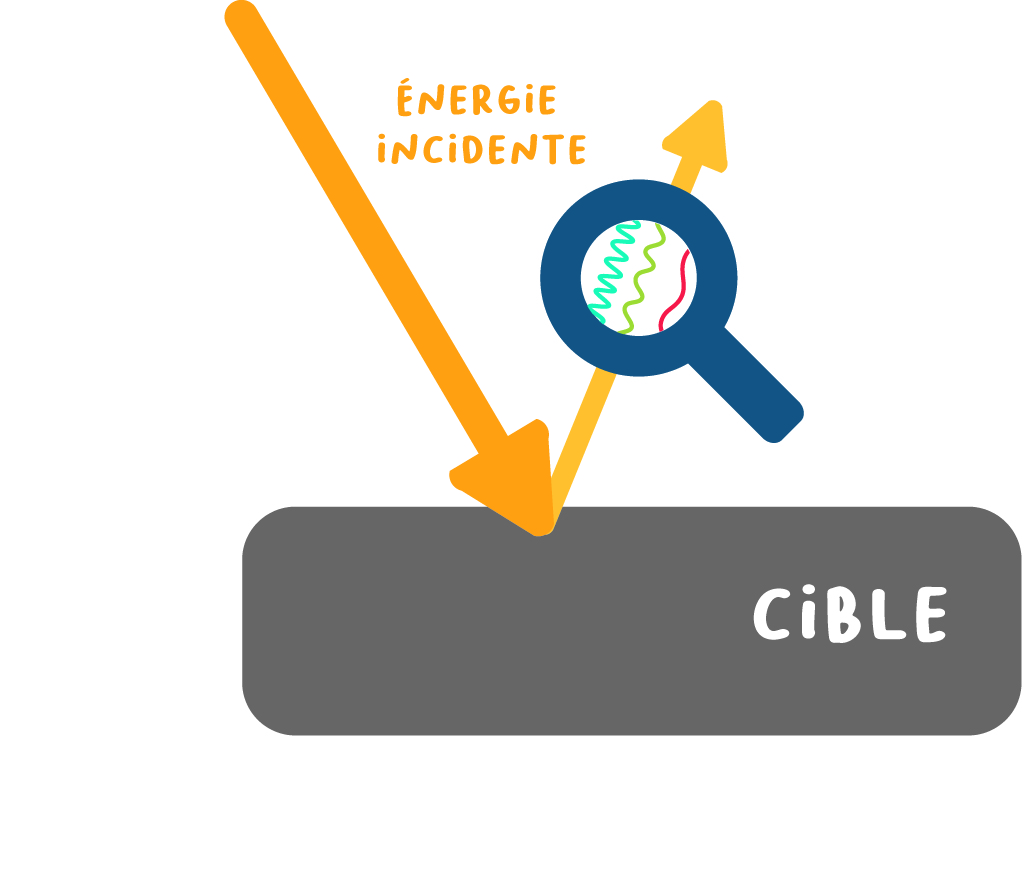

Techniquement, il est important de retenir que l’acquisition et le traitement de toutes ces données s’appuient sur un même principe, le principe de télédétection. Le principe de télédétection peut être schématisé ainsi : la surface de la Terre reçoit un rayonnement (par exemple émis par le soleil) et le réfléchit vers l’espace. Le rayonnement réfléchi est enregistré par un capteur (par exemple à bord d’un satellite), converti en données numériques, renvoyées à une station de réception située sur Terre. Ces données numériques, ou images, sont ensuite analysées et traitées afin d’en extraire des informations utiles.

Ainsi, la télédétection permet d’acquérir des informations sur la surface de la Terre, inédites et complémentaires de celles déjà couramment utilisées (données in situ, données statistiques, etc.). On peut par exemple cartographier et suivre l'évolution de la végétation, des surfaces bâties, des parcelles agricoles, obtenir des informations sur l'humidité des sols, sur la température de surface de la Terre, etc. Autant d'informations utiles pour établir des diagnostics et/ou orienter et évaluer des politiques locales en aménagement du territoire.

Télédétection

Appliquée à l’observation de la Terre, la télédétection désigne la technique d’acquisition d’images et les techniques de traitement de ces images dans le but d’obtenir des informations sur la surface de la Terre, sans contact direct avec celle-ci.

Ce processus de transformation des images en informations ou services utiles et utilisables par des entreprises, administrations et citoyen est souvent présenté comme une « chaîne de valeur » qui fait intervenir des acteurs très variés, mobilisant différentes disciplines, œuvrant dans différents secteurs et qui ont chacun leurs habitudes de travail et leur vocabulaire. Cette chaîne de valeur est qualifiée par les acteurs du secteur spatial de chaîne « aval » par opposition à toute la chaîne « amont » (étapes de conception et de lancement des satellites et capteurs, réception des images). Par déclinaison on parle donc de produits, services et applications aval pour qualifier les produits présentés dans ce visualiseur.

La transformation d’images en produits est généralement testée dans un premier temps sur des portions de territoire restreintes sur lesquelles les chercheurs disposent de jeux de données importants (images satellitaires, photographies aériennes, relevés terrains, etc.). On parle alors de « preuve de concept » : les chercheurs testent de nouveaux algorithmes et publient les méthodes mobilisant des images satellitaires permettant de répondre à une question donnée sur un territoire. Mais pour passer à une phase opérationnelle, il est nécessaire de généraliser ces méthodes et produits sur de plus vastes territoires, on parle alors de « mise en production ». Cette dernière soulève de nombreux enjeux : adaptation de méthodes à d’autres territoires, besoin de données terrain (in situ), traitement de jeux de données très volumineux, etc.

L'imagerie satellitaire (aussi appelée imagerie spatiale) désigne la prise d'images depuis l'espace, par des capteurs placés sur des satellites. Visuellement, les images satellitaires ressemblent beaucoup à des photos, mais elles contiennent bien plus d'informations. Cet article propose d'aborder (de façon simplifiée) les notions essentielles pour savoir lire une image de télédétection.

En préalable, quelques notions sur le rayonnement

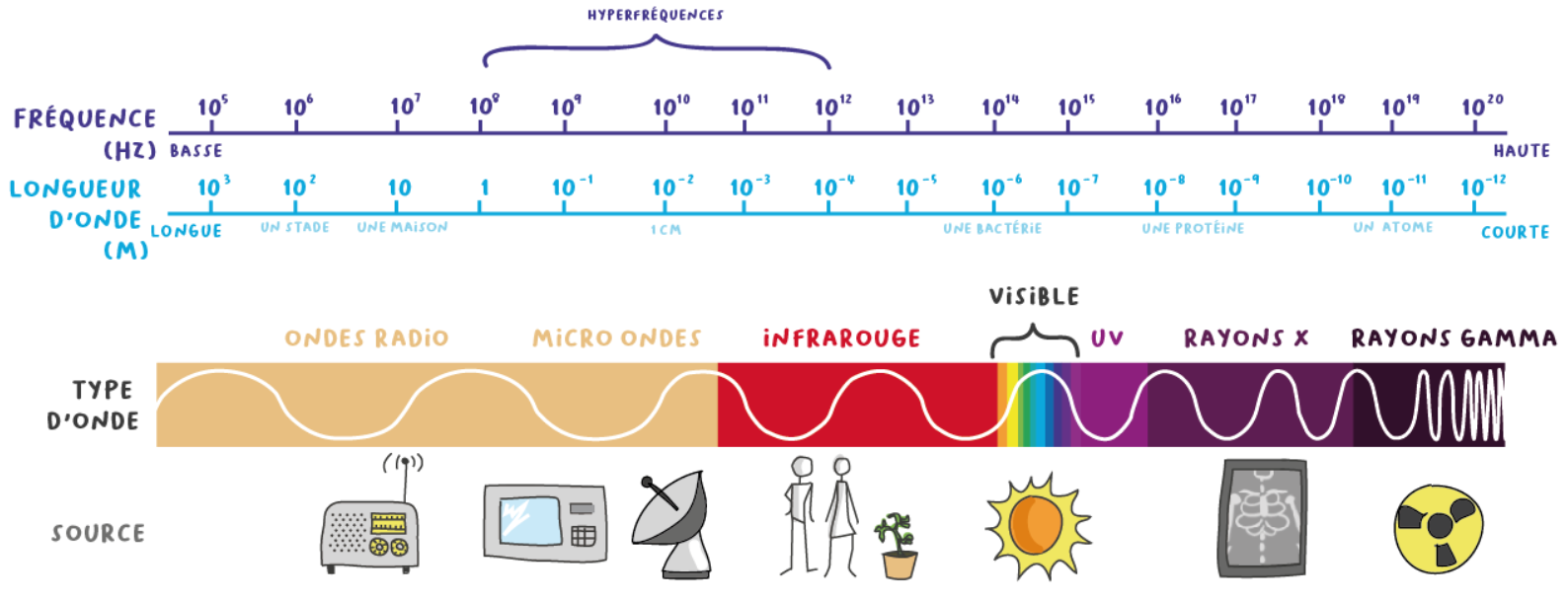

Pour comprendre les informations que contiennent différents types d’images satellitaires, rappelons quelques notions sur les ondes électromagnétiques.

Le soleil émet un rayonnement qui se propage sous forme d’ondes. Ces ondes traversent l’espace puis l’atmosphère avant d’arriver à la surface de la Terre où une part d’entre elles est réfléchie vers l’espace.

Ce rayonnement et les différentes ondes qui le composent sont représentés sous la forme d’un spectre électromagnétique. Les ondes sont caractérisées par leurs longueurs d’onde et leurs fréquences (deux grandeurs inversement proportionnelles). On parle par exemple de grandes ondes, de micro-ondes, d’ultraviolet, d’infra-rouge, etc. Dans le spectre visible, chaque couleur perçue par notre œil correspond à un intervalle de longueur d’onde.

Le soleil n’est pas la seule source de rayonnement électromagnétique, de nombreuses autres sources émettent des ondes, qu’elles soient visible ou non. Les domaines d'application du spectre électro magnétique sont nombreux : on utilise les ondes micro-ondes pour chauffer ou cuire des aliments, les rayons X pour les radiographies médicales, les rayonnements infrarouges émis par les être vivants pour observer des animaux de nuit, etc.

Image optique et image radar

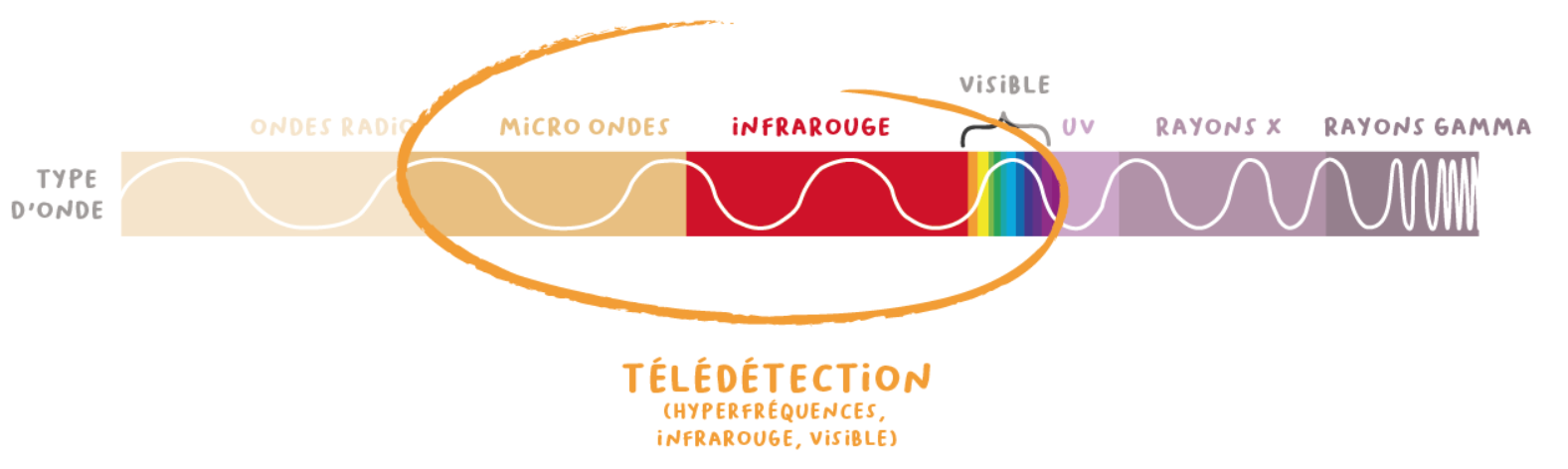

En observation de la Terre on peut exploiter :

des ondes émises par le soleil puis réfléchies par la surface de la Terre et enregistrées par un capteur placé sur un satellite ;

des ondes émises par un émetteur artificiel placé sur le satellite puis réfléchies par la surface de la Terre et enregistrées par un capteur placé sur ce même .

Dans le premier cas on parle de télédétection passive et d’images optiques, dans le second cas de télédétection active et d’images radar.

La télédétection radar présente l’avantage de :

s’affranchir des contraintes de couverture nuageuse : les ondes émises par les satellites traversent les nuages ;

pouvoir acquérir des images de jour comme de nuit.

En revanche, leur exploitation pour l’observation de la Terre est moins intuitive et une expertise est nécessaire pour interpréter des images qui ressemblent bien moins à une photo que les images optiques.

Ainsi, différents domaines spectraux sont exploités en télédétection optique (longueurs d’onde du visible à l’infrarouge) et en télédétection radar (micro-ondes ou plus couramment appelées hyperfréquences dans le domaine de la télédétection).

Images satellitaires et résolution spatiale

Lorsque l’on prend une photographie classique, l’information est traduite par des formes et des couleurs, qui correspondent à des groupes de pixels plus ou moins homogènes. Sur une même scène photographiée prise par deux appareils, plus les pixels seront nombreux dans l’image plus la résolution spatiale sera élevée. On le voit aisément lorsque l’on souhaite faire un agrandissement et que l'on voit apparaître les pixels en zoomant sur une image.

Il en va de même pour une image satellitaire : selon les caractéristiques du capteur, l’altitude du satellite (donc son orbite autour de la Terre), les images seront composées de pixels couvrant une surface au sol plus ou moins grande du sol. On classera ainsi les images enregistrées en images :

Basse résolution

Moyenne résolution

Haute résolution (HRS)

Très haute résolution (THRS)

Les images composées de pixels sont appelées des images "raster", à la différence des images "vecteur", composées de points, lignes et surfaces auxquels sont associés des attributs.

Résolution spatiale

La résolution spatiale est la taille du plus petit élément qu’il est possible de distinguer sur l’image. Elle est également couramment définie comme étant la taille du pixel. Sur une image, les objets qu'il sera possible de discerner dépendront de la résolution spatiale du capteur utilisé. Généralement, plus la résolution spatiale augmente, plus la superficie de la surface visible par le capteur diminue : une image très haute résolution couvrira une portion de territoire plus restreinte qu'une image moyenne résolution. Au moment du choix des images à traiter, il convient donc de choisir le bon compromis selon la taille des objets les plus petits que l'on veut observer, et l'échelle à laquelle on souhaite observer un processus.

En SIG, les vecteurs sont souvent utilisés pour la cartographie. Ils permettent de simplifier une représentation d'un territoire. Certains rasters sont couramment utilisés comme les photographies aériennes, les Modèles numériques de terrain (MNT), ou la couche adresse du BD Parcellaire.

Quelle grandeur utilise-t-on pour les valeurs des pixels ?

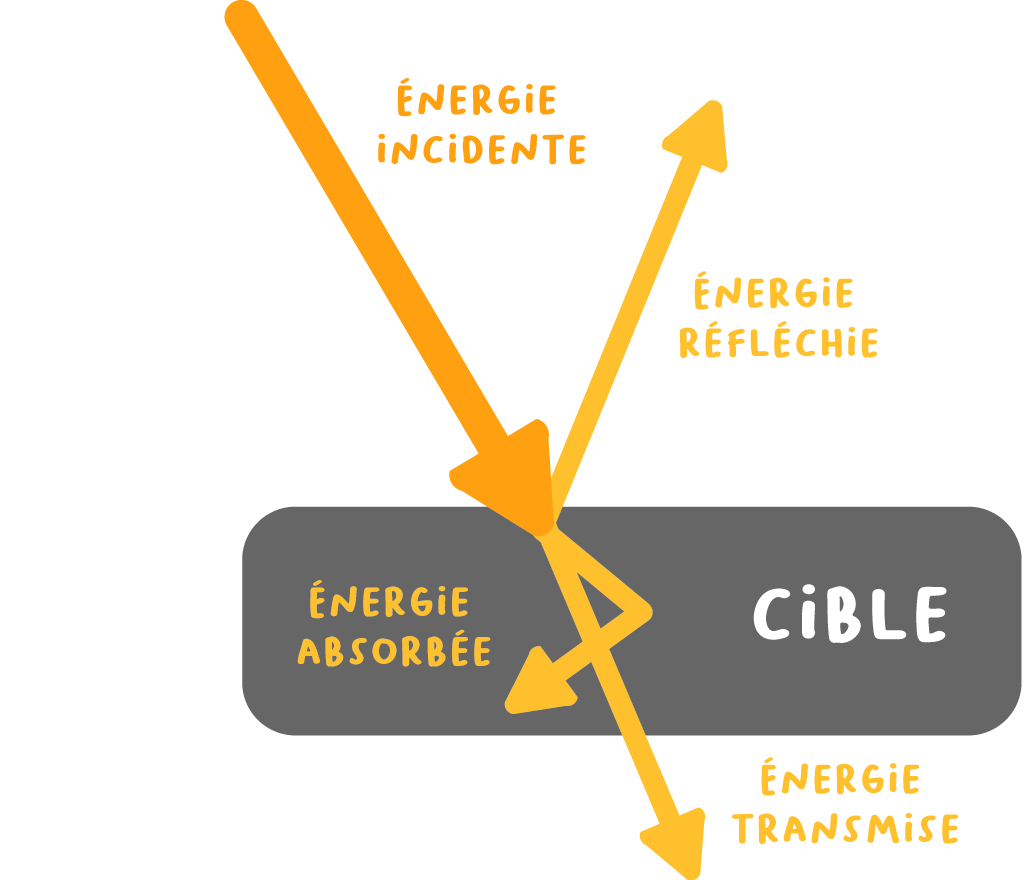

En télédétection, la grandeur utilisée pour décrire la « teinte » des pixels est la réflectance (on parle de réflectivité pour les images radar). La réflectance va traduire le comportement d’une surface lorsqu’elle qu’elle reçoit les rayons du soleil. Soumise à un rayonnement, une surface (la cible) va en partie :

l’absorber

le transmettre aux surfaces sous-jacentes

le réfléchir vers le ciel. C’est cette part réfléchie qui est enregistrée par les capteurs des satellites.

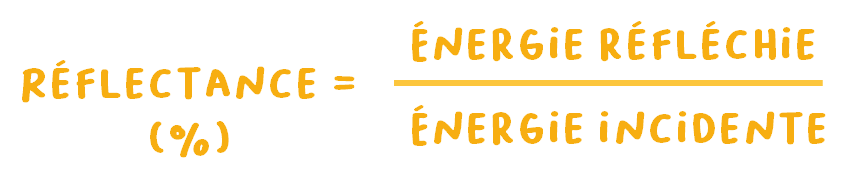

La réflectance

La réflectance est une grandeur qui traduit la proportion de lumière réfléchie par la surface d'une cible. Elle est définie comme le rapport entre le flux lumineux réfléchi et le flux lumineux incident et s'exprime généralement en pourcentage.

Dans cet article nous ne rentrons pas dans les détails des définitions et calculs de grandeurs utilisées en télédétection, pour approfondir, vous pouvez consulter cet article du Cesbio.

Images satellitaires et résolution spectrale

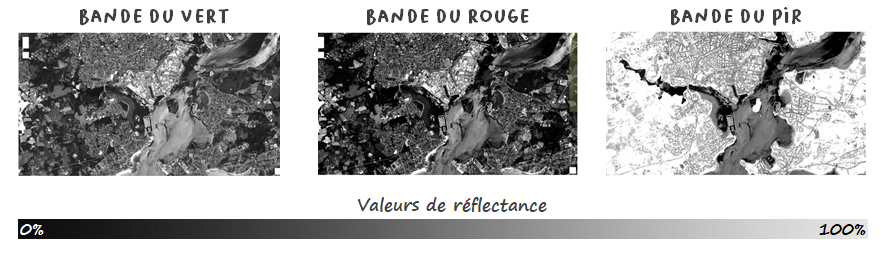

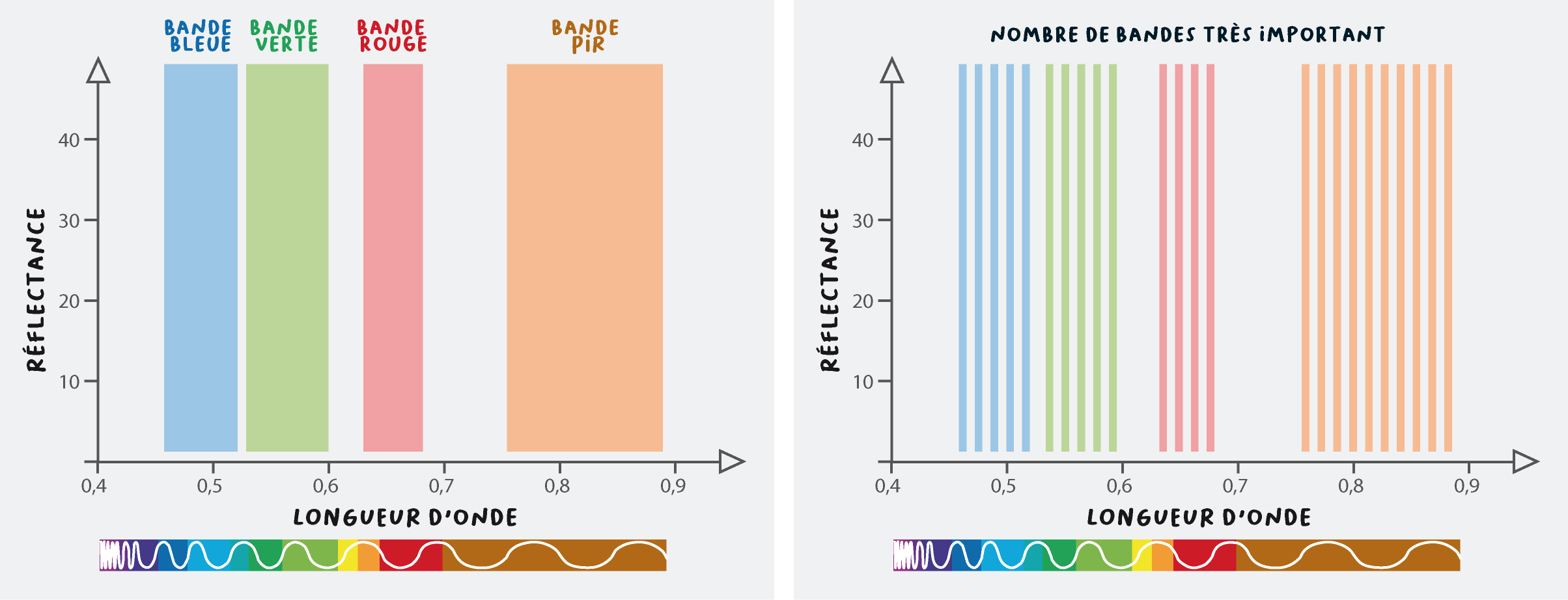

Dans une images satellitaire, l’information sur les couleurs est contenue dans différents canaux ou bandes spectrales. Chaque bande est une image en niveaux de gris, composée de pixels ayant chacun une valeur de réflectance pour un intervalle de longueur d’ondes donné. On parle ainsi de "bande du bleu", du "rouge, du proche infrarouge", etc. Chaque bande va couvrir une portion plus ou moins large du spectre électro magnétique. Par exemple, la bande du bleu correspond à des longueurs dans un intervalle autour de 480 nm, celle du rouge autour de 600 nm.

Pour reprendre l'analogie avec une photographie classique, dans une photo, l’information sur les couleurs est contenue dans 3 bandes : la bande des longueurs d’ondes correspondant à la couleur bleue (B pour bleu ou blue), verte (V pour vert ou G pour green) et rouge (R pour rouge ou red). On voit ainsi souvent les acronymes RVB et RGB dans les logiciels de traitement de photos. Chacune de ces trois bandes est en niveau de gris.

Bande spectrale / Canal spectral

Chaque bande spectrale est une image raster en niveau de gris qui représente les valeurs de réflectance des surfaces au sol pour un intervalle de longueurs d’ondes donné.

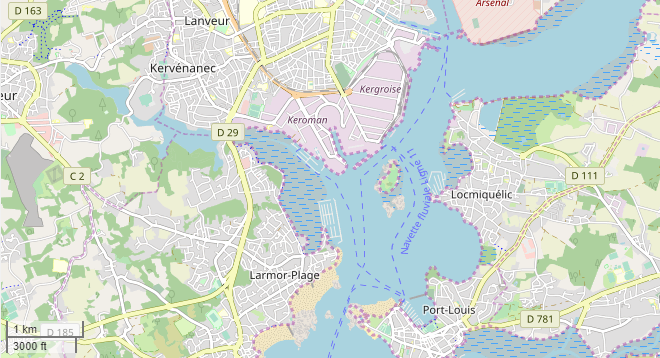

Prenons l'exemple des images ci-contre. L'illustration montre 3 images de la rade de Lorient (voir plan ci-dessus pour vous repérer), correspondant chacune à une bande spectrale. Les valeurs de réflectance changent selon l'intervalle de longueur d'onde considéré. Dans l'intervalle de longueur d'onde correspondant aux couleurs vertes et du rouges, la végétation a des valeurs de réflectance basses, alors qu'elle a des valeurs élevée dans l'intervalle des longueurs d'onde de l'infrarouge. L'eau a des valeurs de réflectance basse dans les 3 bandes. Pour information, les variations de valeur de réflectance de l'eau correspond aux matières en suspension qu'elle transporte.

Une image satellitaire, selon les caractéristiques du capteur embarqué sur le satellite, peut contenir en plus des trois bandes du visible (RVB) quelques bandes supplémentaires (par exemple infrarouge, proche infrarouge), et jusqu’à des centaines de bandes. Ces bandes vont couvrir des intervalles plus ou moins large du spectre électromagnétique. On parle ainsi d’images multi-spectrales (quelques bandes) ou d’images hyper-spectrales (des dizaines à des centaines de bandes).

Résolution spectrale

La résolution spectrale décrit la capacité d'un capteur à utiliser de petites fenêtres de longueurs d'onde. Plus la résolution spectrale est fine, plus les fenêtres des différents canaux du capteur sont étroites (définition RNCAN).

On peut représenter les valeurs de réflectance des bandes selon un graphique, avec en abscisse les longueurs d'onde du spectre électromagnétique, et en ordonnée les valeurs de réflectance en %. On illustre ainsi la nature de l'information contenue dans une images satellitaire composée de plusieurs bandes ou canaux. Sur le premier graphique, le capteur embarqué sur le satellite va enregistrer peu d'information sur les caractéristiques spectrales des cibles (visible sur les pixels) : l'image sera composée de 4 bandes, qui couvriront chacune un intervalle de longueur d'onde assez large. Dans le second cas, le capteur va enregistrer une grande quantité d'information spectrale : pour chaque couleur, plusieurs bandes sont enregistrées. Non seulement le nombre de bandes est plus élevé, mais en plus chaque bande traduit des valeurs de réflectance pour de petits intervalles de longueur d'onde.

Généralement, une très haute résolution spectrale est possible au détriment de la résolution spatiale. Les images hyperspectrales sont par exemple très intéressantes pour discriminer des espèces végétales différentes. Tout l'intérêt est de pouvoir combiner les 2 types d'images, ce qui soulève des questions méthodologies.

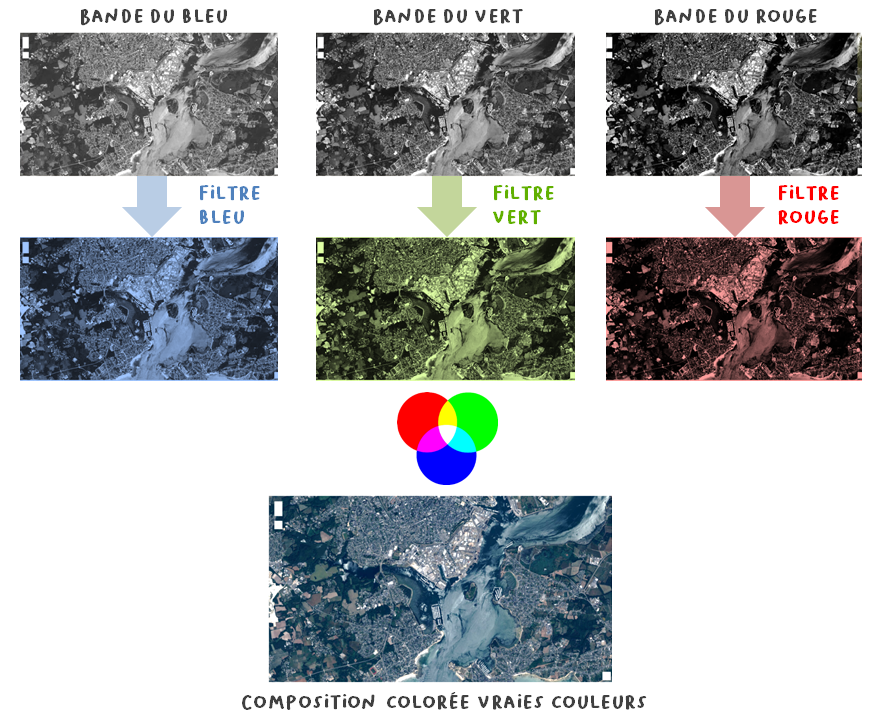

L'affichage des images en couleur

Sur une image classique, on reconstitue à l’écran ce que notre œil voit en affectant un filtre coloré correspondant à la "vraie" couleur de chaque bande, (c’est le principe de la synthèse additive : toutes les couleurs du spectre visible additionnées, ou les 3 couleurs primaire additionnées donnent de la lumière blanche). On parle alors de composition colorée vraies couleurs. Le principe est le même pour les images satellitaires, si l'on souhaite afficher une images optique telle que notre œil verrait la Terre depuis le ciel, on affectera aux trois bandes du visible bleu, du vert et du rouge leurs vraies couleurs.

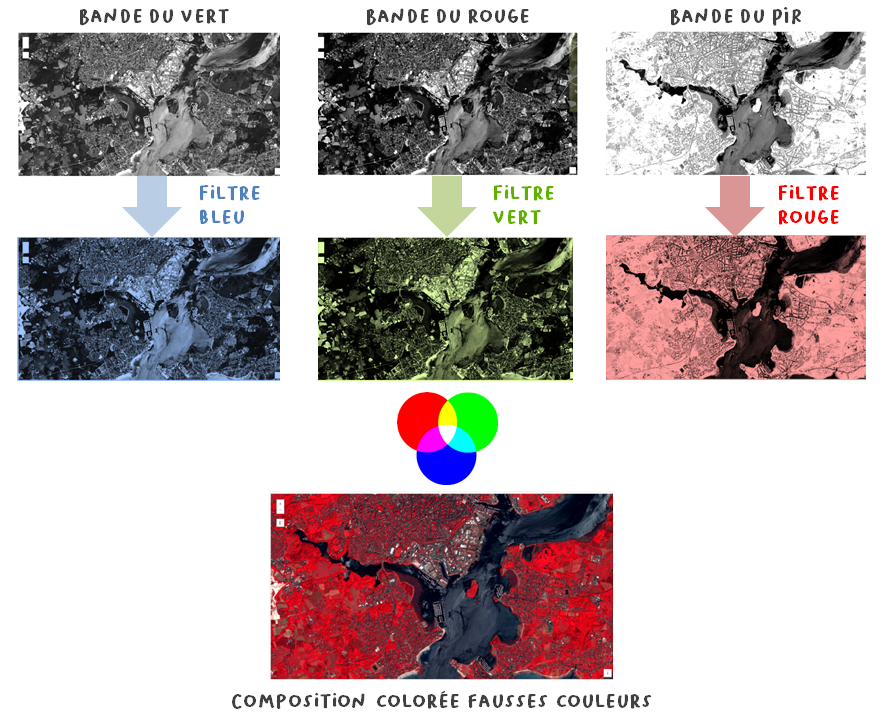

Sur l'illustration ci-après (toujours la rade de Lorient), sur la composition colorée vraie couleur la ville apparaît avec des couleurs blanches et grises, l'eau dans différentes teintes de bleu, et la végétation en vert foncé : on a recréé ce que verrait notre œil.

Le principe est le même pour les images satellitaires, si l'on souhaite afficher une images optique telle que notre oeil verrait la Terre depuis le ciel, on affectera aux trois bandes du visible bleu, du vert et du rouge leurs vraies couleurs.

Le principe de la composition colorée

La réalisation d'une composition colorée consiste à attribuer à chaque couleur primaire (rouge, vert et bleu) trois bandes spectrales d'un capteur satellitaire. Par synthèse additive, il est possible de reconstituer toutes les couleurs. Cela permet de faciliter l'interprétation des images satellitaires et de mettre en évidences des phénomènes environnementaux.

En faisant cela, on ne visualise pas les informations contenue dans d’autres bandes que les bandes Rouge-Vert-Bleu, informations non visibles par l'œil humain. De manière conventionnelle en observation de la terre, on affecte à la bande du proche infrarouge un filtre rouge, à la bande du rouge un filtre verte et à la bande du vert un filtre bleu. On parle alors de composition colorée "fausses couleurs". Dans cette représentation, les informations contenues dans la bande du bleue ne sont pas représentées. Peu intuitive au départ, cette représentation a l’avantage de rendre visible des informations non visibles à l’œil nu, et de bien discriminer surfaces minérales et surfaces végétales. Différentes compositions colorées fausses couleurs sont utilisées selon les disciplines et selon l'objet que l'on souhaite faire ressortir à l'image.

Sur cette composition colorée fausses couleurs, la végétation apparaît en rouge, les surfaces minérales et le bâti en bleu, gris et cyan, l'eau claire en noir, et l'eau chargée en matières en suspension d'origine minérale en bleu et gris (comme le bâti). Si l'eau avait été chargée de micro-algues, on aurait vu des zone plus rouges dans l'eau (comme la végétation).

Comment distingue-t-on différents types de couverture du sol sur une image ?

Soumise à un rayonnement, différentes cibles auront des comportements différents : des cibles de même nature absorberont ou réfléchiront davantage certaines longueur d'ondes. Des cibles de nature différente auront pour un même intervalle de longueur d'onde (donc une même bande spectrale) des comportements différents. En étudiant la nature du spectre réfléchi par une cible, on peut obtenir des informations sur cette cible, sur sa nature, son état.

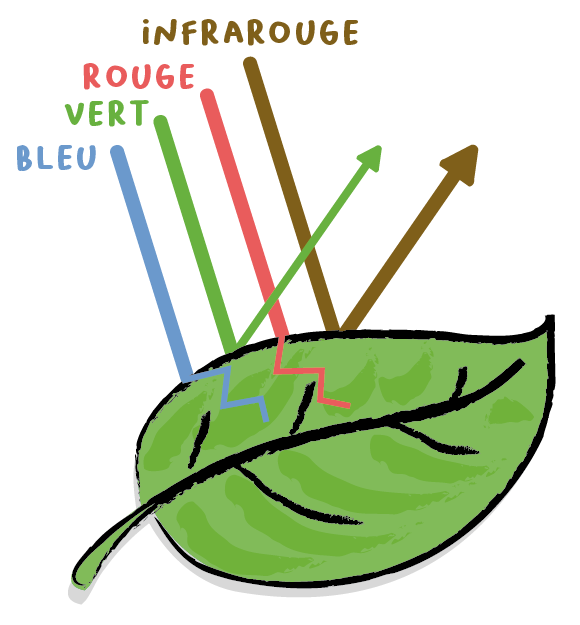

Par exemple, les feuilles d’une plante en bonne santé vont absorber les longueurs d’onde du rouge et du bleu (pour les besoins physiologiques de la plante, puisque les végétaux convertissent l'énergie lumineuse en énergie chimique par le processus de photosynthèse), et réfléchir les longueurs d’ondes du vert. Ainsi, nous voyons les feuilles de couleur verte. Au-delà du domaine du visible, la végétation réfléchi de manière très importante les longueurs d’ondes de l’infrarouge et du proche infrarouge (PIR). C'est pour cela que sur l'image des la rade de Lorient, la végétation apparaissait en blanc sur l'image de la bande PIR. Autrement dit, les valeurs de réflectance de la végétation sont élevées dans la bande du PIR.

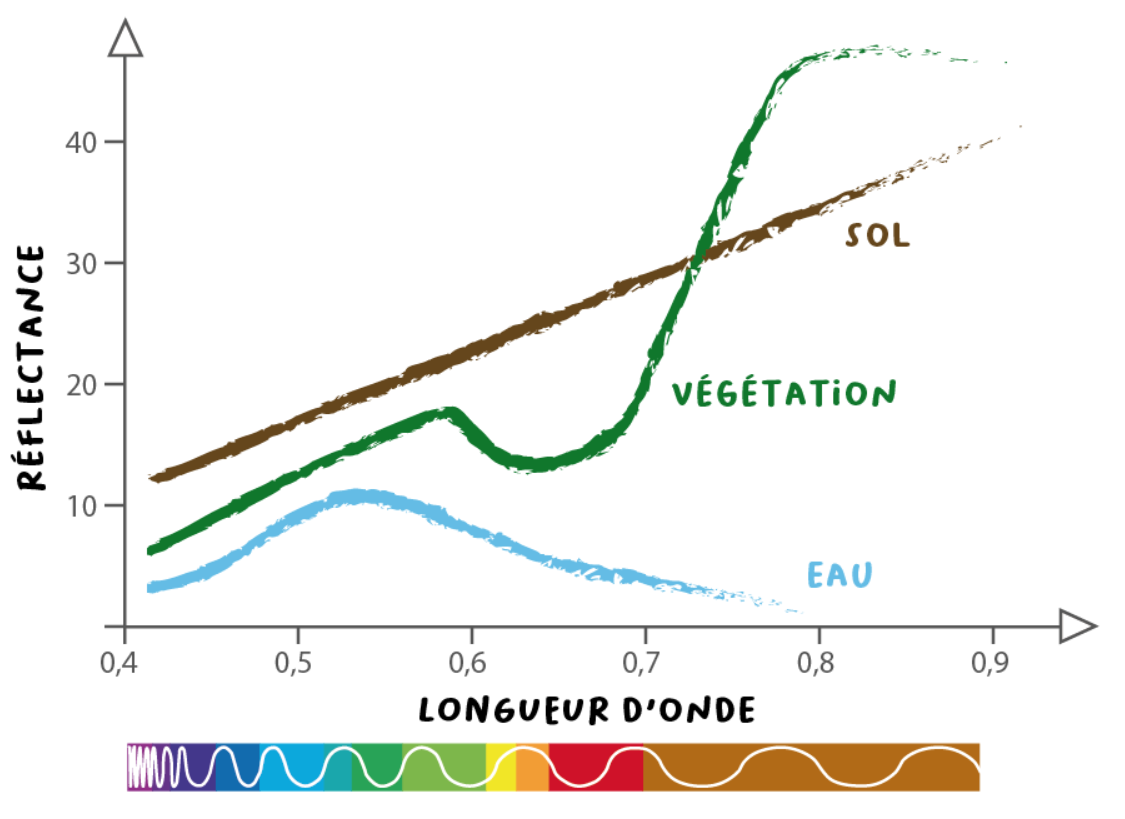

Il est possible de caractériser des cibles de différente nature selon leur réponse spectrale à différentes longueur d'onde. On parle de signature spectrale d'une cible (ou d'un type de surface). On peut représenter graphiquement les signatures spectrales des principaux matériaux.

Signature spectrale

Lorsqu’elles sont soumises à une source d’énergie, différentes cibles ont différents comportements. La variation de la réflectance en fonction de la longueur d’onde est appelée signature spectrale.

Sur le graphique sont schématisées la signature spectrale d'un sol nu, de la végétation et de l'eau. On voit que certaines bandes permettent de mieux discriminer différents types de couverture du sol.

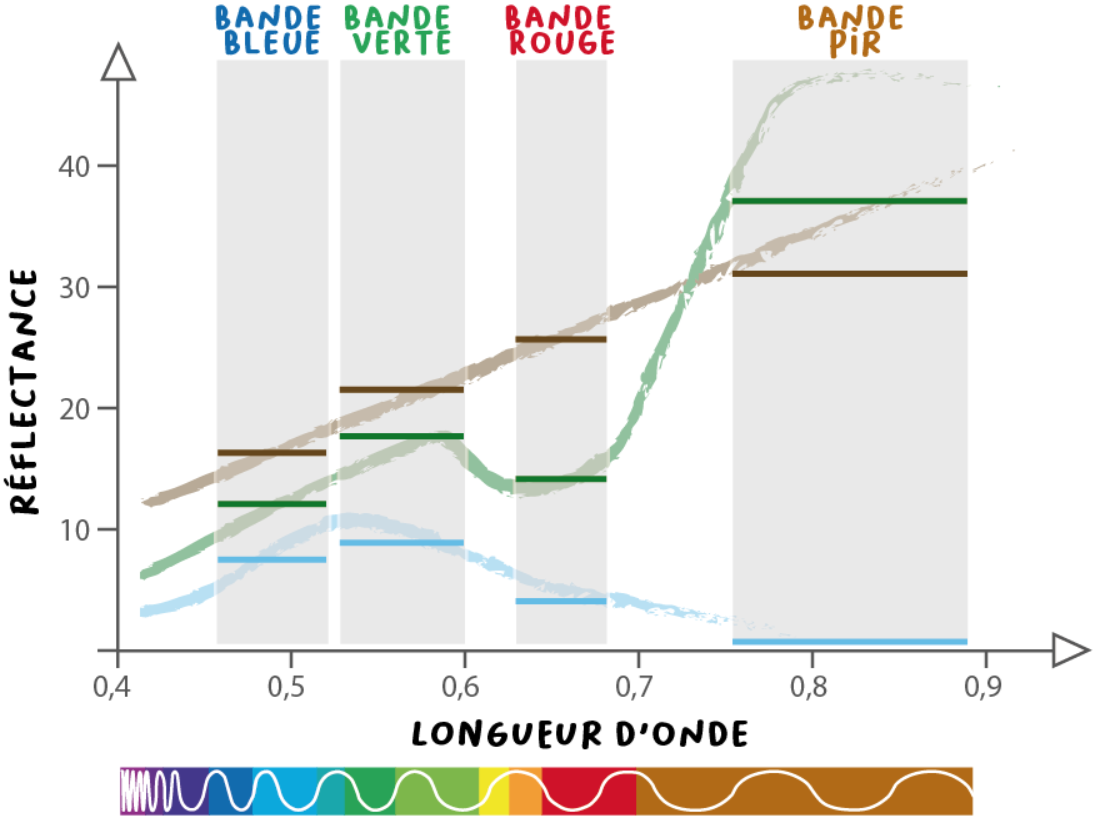

Lorsque l'on étudie des images satellitaires, on dispose en réalité d'une information discrète. On peut l'illustrer en superposant l'illustration de la résolution spectrale des images et les signatures spectrales.

Sur cette illustration simplifiée, on voit que certaines longueurs d'ondes sont plus discriminantes que d'autres pour des types de cibles donnés : la végétation a des valeurs très élevées dans la bande du PIR. Néanmoins, des confusions peuvent apparaître : dans cette même bande, un sol nu aura aussi les valeurs de réflectance élevées. La partie traitement des images visera à exploiter conjointement les valeurs de réflectance dans les différentes bandes pour en extraire une information pertinente au regard d'une problématique. Ceci fera l'objet d'un autre article sur les méthodes de traitement des images.